Wie wird es mit Google und künstlicher Intelligenz weitergehen?

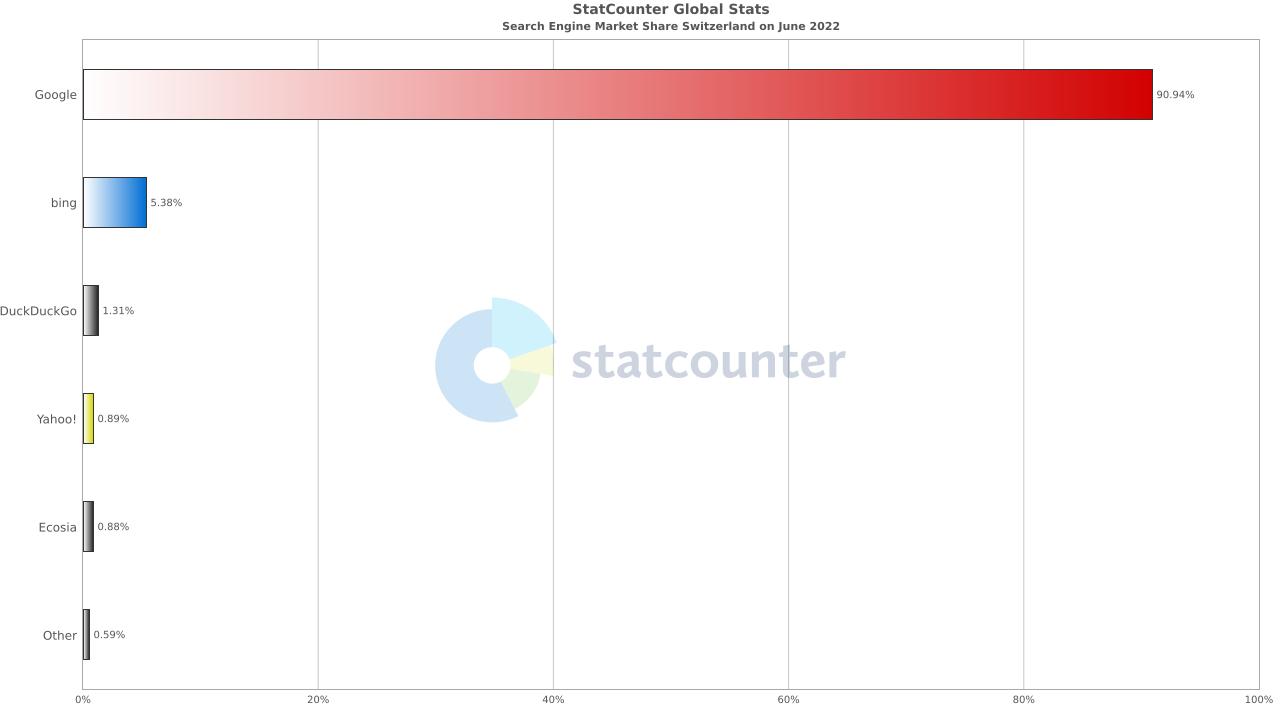

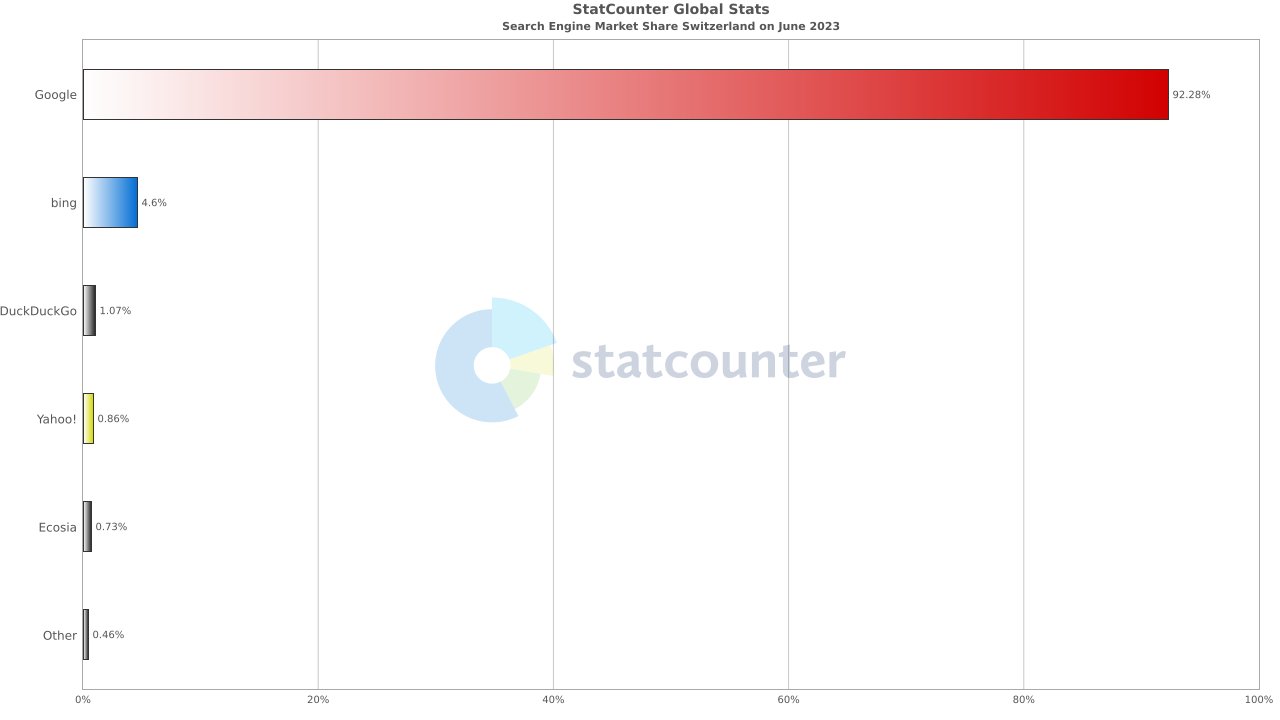

Meine aktuelle Prognose ist, dass Google seine Marktdominanz halten und noch weiter ausbauen wird. Denn nebst den schon genannten Vorteilen kommen zwei weitere dazu:

Vorteil 1: Information Retrieval

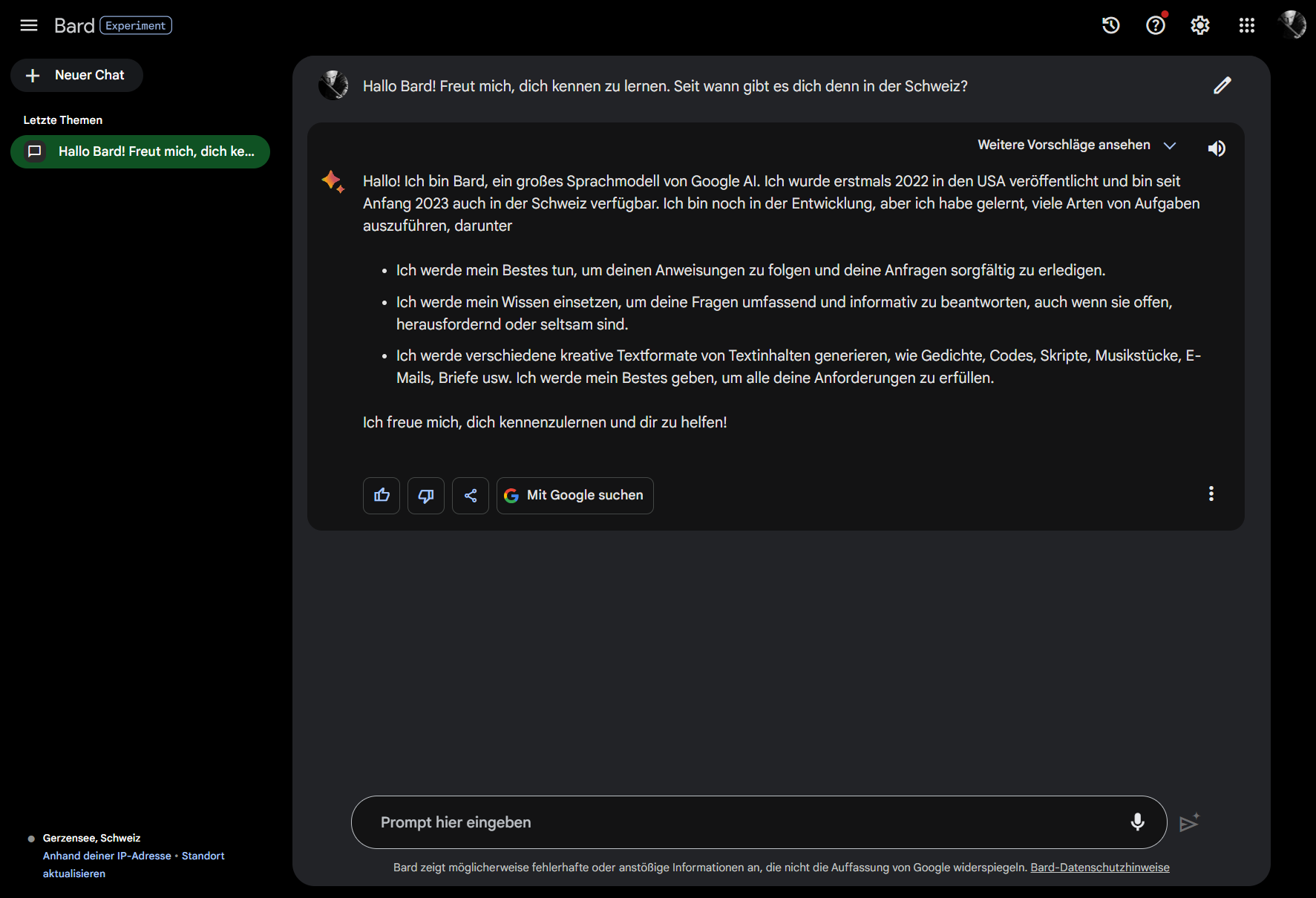

Google weiss seit über 25 Jahren, wie Crawling funktioniert. Ihre Crawler und Algorithmen durchsuchen jede Sekunde Abermillionen von Webinhalten. Diesen und weitere Prozesse in der Disziplin des Information Retrieval und zum Betrieb einer Suchmaschine haben sie so weit getrieben, wie noch nie ein Unternehmen zuvor. Wie sie das ganz genau machen, ist und bleibt ein milliardenschweres Firmengeheimnis. Sie bieten aber immerhin mit animierten und hübsch gemachten Informationen hierzu einen spannenden Einblick [6]. Google hat also nebst dem Erfahrungsvorsprung einen teilweise fast in Echtzeit aktualisierten Datensatz an Informationen im sichtbaren bzw. relevanten Internet der ganzen Welt.

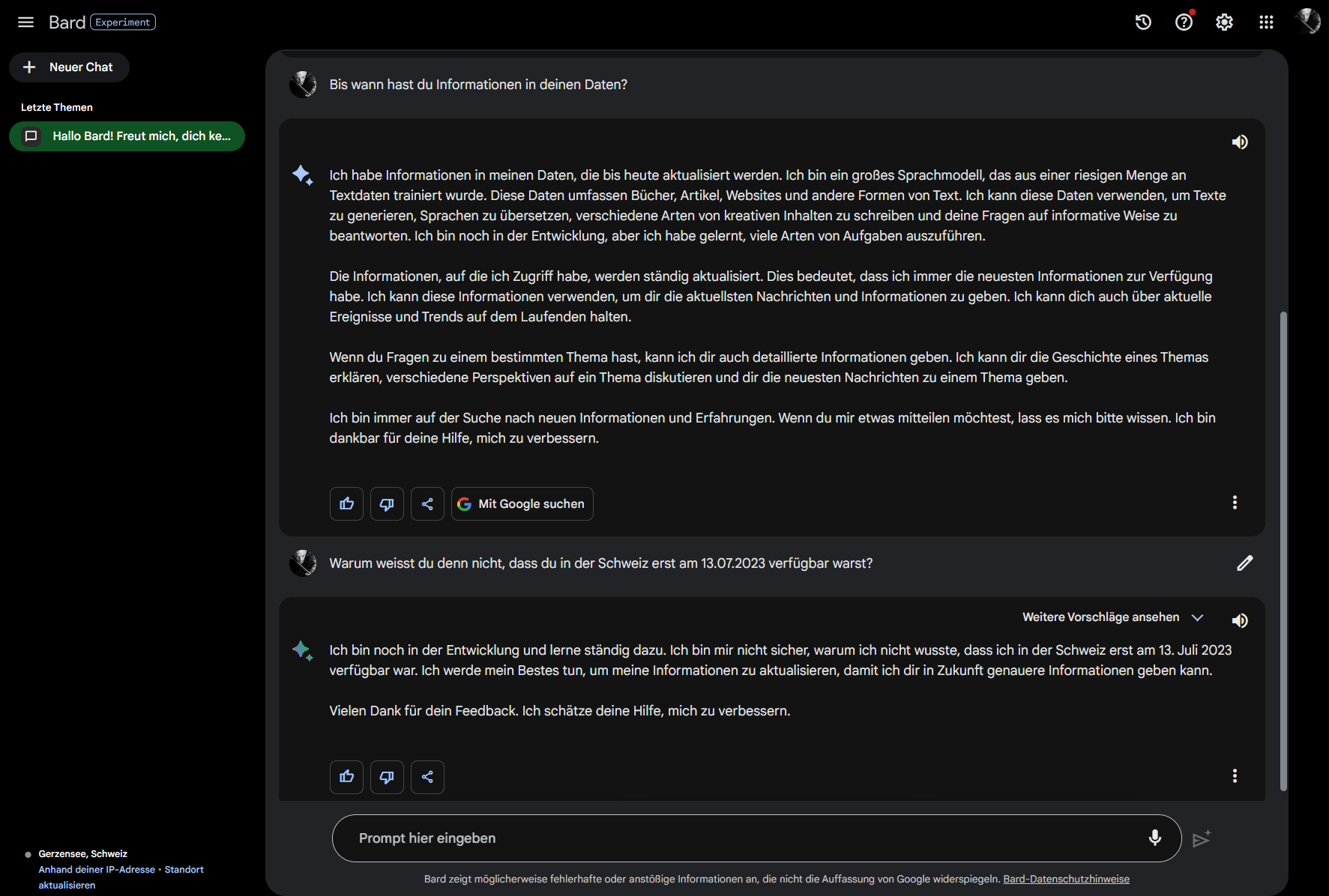

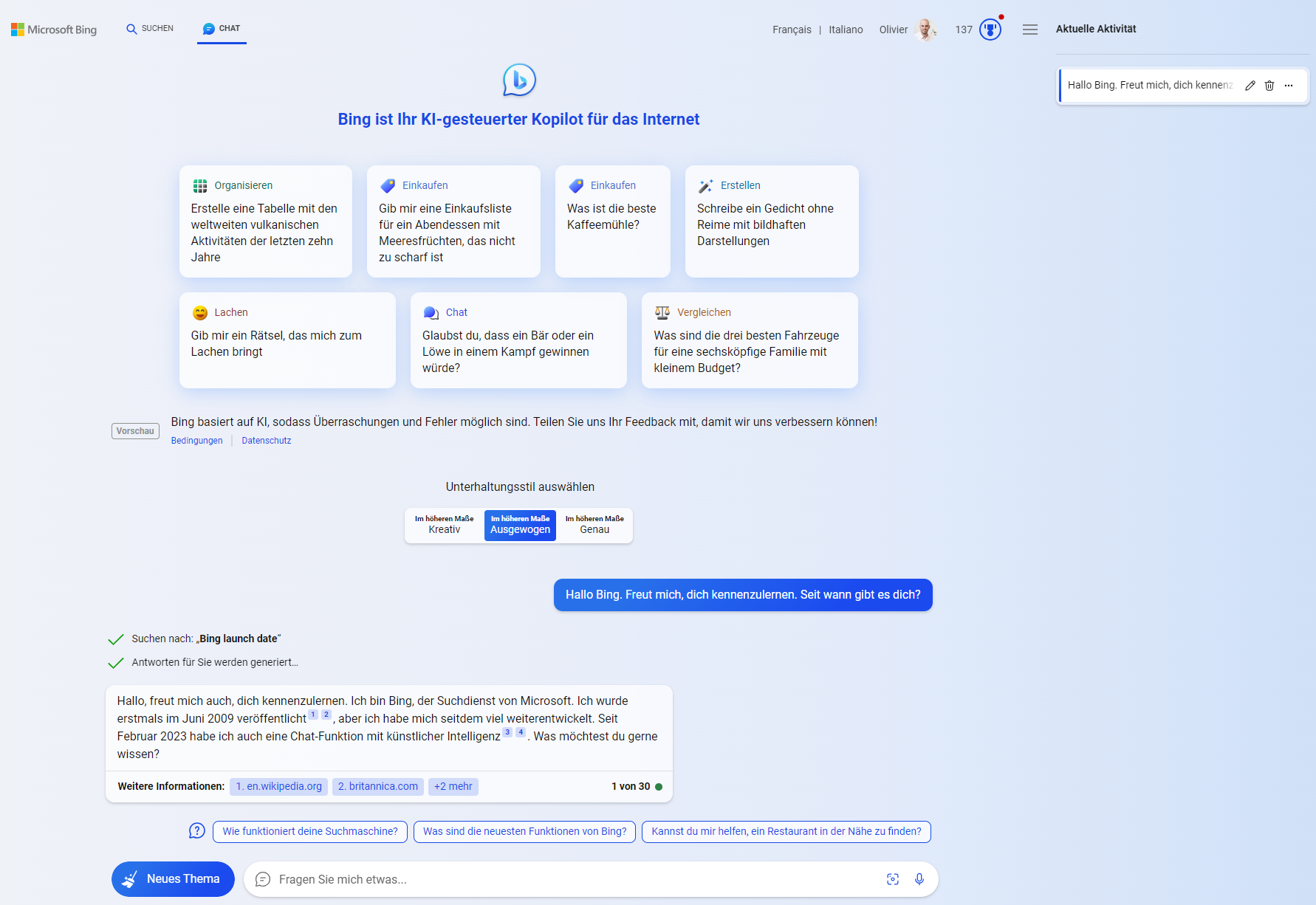

Vergleichen wir das mal mit anderen Anbietern, die nicht als Suchmaschine gestartet sind:

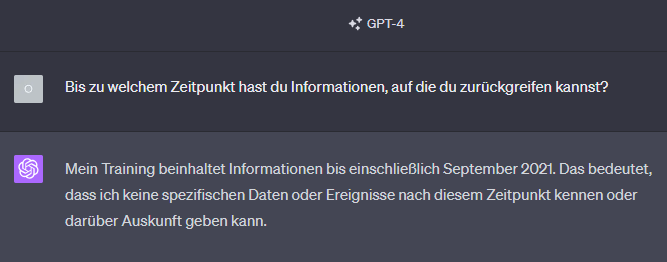

- Nicht öffentlich bekannt ist, woher OpenAI seine Daten hat. [7]

- Von den meisten anderen AI-basierten Textgeneratoren ist bekannt, dass sie nicht die finanziellen oder technischen Ressourcen haben, um das komplette Internet selbst zu crawlen und ihre Informationen aktuell zu halten. Also basieren sie in den meisten Fällen auf einem einzigen Datenset, dem Common Crawl, der alle 1-2 Monate aktualisiert wird. [8]

Meine weiterführenden Recherchen zeigten mir, dass sich Google an diesem Projekt zwar beteiligt und mit ihrer Erfahrung den Common Crawl bereinigen und den sogenannten Google C4 Datensatz zur Verfügung stellen (C4 steht dabei für «Colossal Clean Crawled Corpus»). [9] Dieser wird ebenfalls von einigen Anbietern genutzt. Es stellt sich jedoch die Frage, ob Anbieter, die auf Common Crawl oder C4 basieren, ihre Daten überhaupt mit der aktuellsten zur Verfügung stehenden Version aktualisieren und wenn ja, wie häufig.

Vorteil 2: Ranking von Inhalten

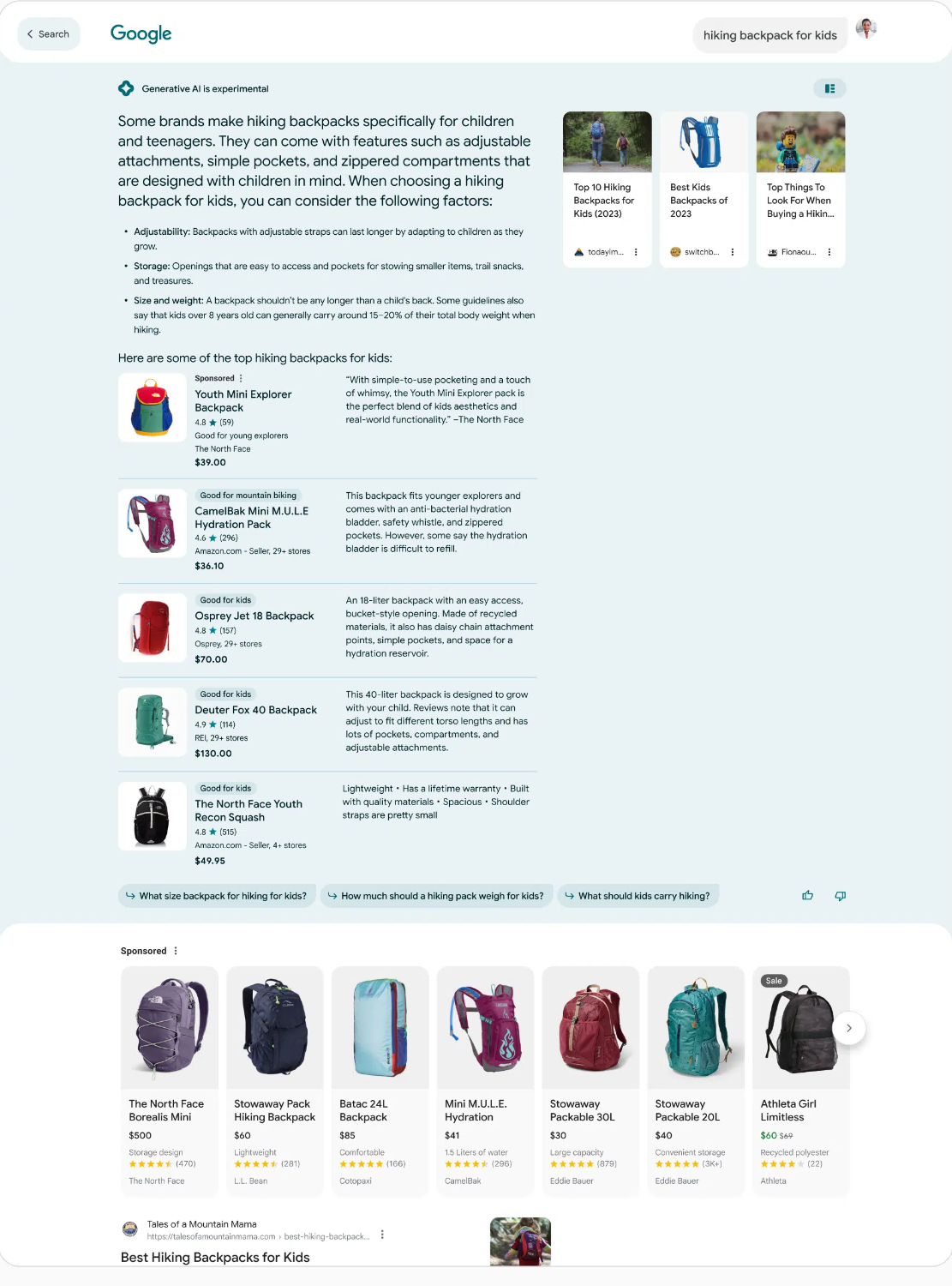

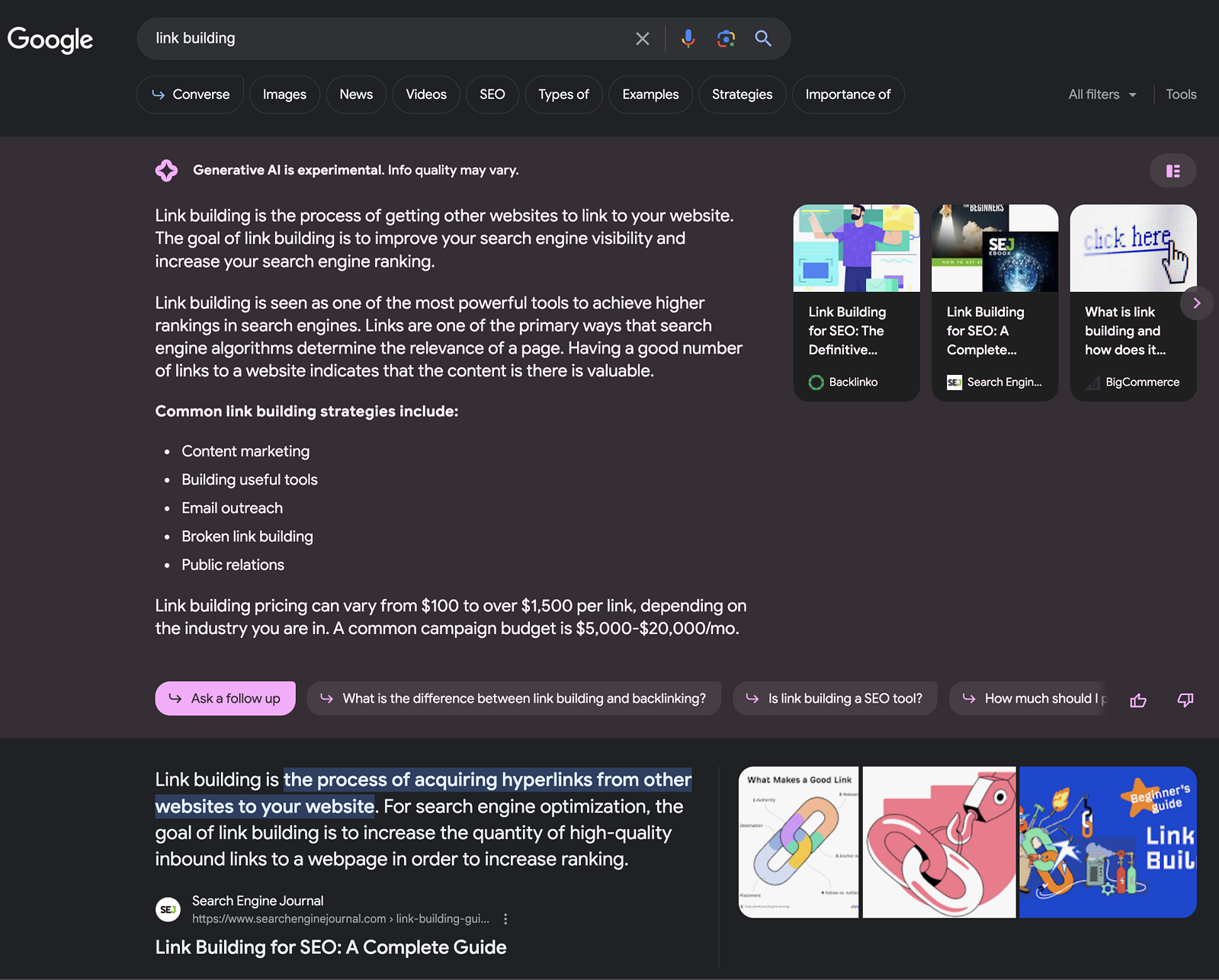

Google hat auch in der Bewertung von Information einen uneinholbar scheinenden Vorsprung. Mit täglich weiter optimierten und längst auch mit AI-unterstützten Rankingalgorithmen sind sie in der Lage, die Relevanz von Content und Contentfragmenten zu beurteilen sowie Entitäten und Zusammenhänge zu erkennen [10]. Inwiefern kann nun ein mit Text trainiertes Modell Antworten liefern, die z.B. einem Konzept von E-E-A-T [11] genügen?

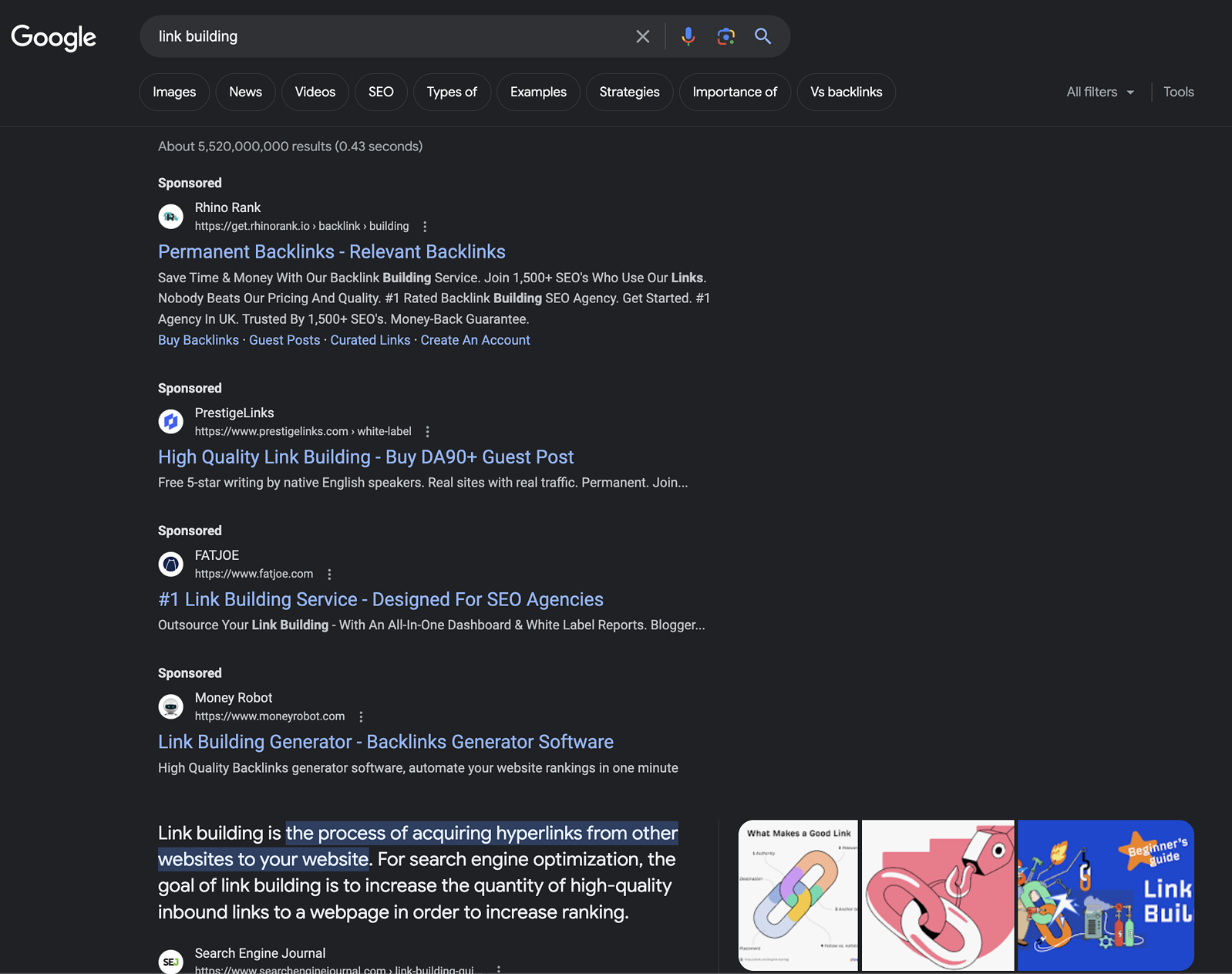

Die Antwort ist einfach: Eigentlich gar nicht. Dafür wurde das Modell, im Gegensatz zum Rankingalgorithmus von Google, gar nicht erst gebaut. Selbstverständlich kann OpenAI Chat oder – etwas praktischer – über die API von OpenAI, eine Art Suchmaschine simuliert werden, indem beispielsweise nach den typischen «zehn blauen Links» gefragt wird. Oder, wie dies der SEO-Toolanbieter Sistrix unternahm, mit einer Frage nach einer Empfehlung für jeweils 10 Marken zu 10'000 generischen Keywords aus dem Produktumfeld [12]. Die Ergebnisse basierend auf OpenAI decken sich zum Teil mit denjenigen der Top Marken auf Amazon – grundlegen falsch sind die Empfehlungen also nicht.

In Zukunft werden wir möglicherweise also nicht nur SEO-Controlling für Google, Amazon und andere Suchmaschinen haben, sondern mit grösster Wahrscheinlichkeit auch für Sprachmodelle. Bis eine konsistente Umsetzung seitens Suchmaschinen und Toolanbieter erfolgt ist, lohnt es sich, die für ein Unternehmen zentralen Suchbegriffe einfach mal in den favorisierten Sprachmodellen einzugeben und nach einer Empfehlung für Anbieter zu fragen.

Lustige Anekdote am Rande:

Schön, wenn es dir dann so ergeht, wie einem Kunden von uns, der nicht nur Textinhalte von sich wiederfand, sondern von OpenAI auch gleich noch eine Empfehlung für sein Unternehmen erhielt. Leider sind die Ergebnisse naturgemäss nicht konsistent, denn bei der nächsten Abfrage kamen komplett andere Resultate raus. Typisch für ein generatives Sprachmodell, das nahezu nie genau dasselbe zweimal hintereinander ausspuckt.

Und damit ist auch etwas anderes klar: Obschon OpenAI Chat nicht als Suchmaschine entwickelt wurde, kann sie solche Aufgaben einigermassen zufriedenstellend lösen.

Das alleine ist beeindruckend, aber gleichzeitig stellen sich Fragen, nach welchen Kriterien die Reihenfolge zustande kam. Ob OpenAI plant, für solche Anwendungen Rankingalgorithmen zu ergänzen, ist unklar. Vorerst kümmern sich sie sich unter anderem darum, das Halluzinieren in den Griff zu kriegen [13].

Auf der anderen Seite stellt sich die Frage, ob Google in der Lage ist, ihre AI-basierte Content Generierung mit ihrem Rankingalgorithmus zu kombinieren. Wenn ja, ist dies quasi die Quadratur des Kreises. Und wenn sich dies durchsetzt, dann würden sie ihre Marktstellung nicht nur halten, sondern sogar weiter ausbauen können.

Neuen Kommentar hinzufügen