Was ist robots.txt?

Mit der einfachen Textdatei robots.txt kann Suchmaschinen gezielt mitgeteilt werden, welche Seiten und Verzeichnisse indexiert bzw. nicht indexiert werden sollen.

Zuletzt überarbeitet: Mai 2025

Inhaltsverzeichnis

Die robots.txt-Datei ist ein zentrales Element im Bereich der Suchmaschinenoptimierung (SEO) und des Online Marketings. Sie spielt eine wichtige Rolle in der Kommunikation zwischen einer Website und verschiedenen Suchmaschinen-Crawlern (auch Webcrawler genannt), darunter bekannte Vertreter wie Googlebot, Bingbot, Slurp von Yahoo, der MSN Bot von Microsoft oder spezialisierte Varianten wie Googlebot Image oder Googlebot News. Diese Datei dient dazu, den Zugriff auf bestimmte Seiten oder Verzeichnisse einer Website zu steuern und unerwünschtes Crawling zu verhindern. Ohne sie kann ein Crawler theoretisch die gesamte Website indexieren, was nicht immer gewünscht ist.

Begriff und Definition

Die robots.txt-Datei ist eine einfache Textdatei (auch als robots.txt file oder robots.txt-Datei bekannt), die im Stammverzeichnis (auch Hauptverzeichnis oder Root Verzeichnis genannt) einer Domain gespeichert wird. Ihr Speicherort ist immer https://example.com/robots.txt. Der Begriff stammt vom sogenannten «Robots Exclusion Protocol» oder auch «Robots Exclusion Standard», einem informellen Internetstandard, der erstmals 1994 vorgeschlagen wurde. Dieses Protokoll wird von den meisten seriösen Suchmaschinen und Webservern respektiert. Mit dieser Datei kann man den Zugriff der Suchmaschinen-Crawler auf bestimmte Seiten oder Verzeichnisse einer Website steuern und unerwünschtes Crawling verhindern.

Bedeutung

Die Bedeutung der robots.txt-Datei liegt vorwiegend in der Steuerung der Indexierung. Webmaster, die bestimmte Inhalte – etwa PDF-Dateien, JPG-Bilder oder interne Unterverzeichnisse – von der Indexierung ausschliessen wollen, können dies mit einer korrekt eingerichteten Datei tun. Besonders bei grossen Websites mit vielen Unterverzeichnissen, Subdomains und einzelnen Seiten ist es wichtig, den Zugriff gezielt zu regeln. Auch wenn man bestimmte Verzeichnisse (z. B. /internes/) aus dem Suchmaschinenindex fernhalten oder Crawl-Budgets gezielter einsetzen will, ist die robots.txt ein unerlässliches Werkzeug. Das Crawl-Budget bezeichnet die maximale Anzahl an Seiten, die ein Crawler pro Besuch erfassen möchte – und das ist gerade bei grossen Websites ein begrenzter Faktor. Auch in der strategischen Content-Planung, bei der Priorisierung wichtiger Inhalte oder bei internationalen Websites (z. B. mit Subdomains für verschiedene Sprachen) spielt die robots.txt eine Rolle. In Verbindung mit einer sauber strukturierten Sitemap und gezieltem Einsatz von noindex oder canonical Tags trägt sie wesentlich zur technischen SEO-Optimierung bei. Sie wird von nahezu allen modernen Suchmaschinen wie Google, Bing oder Yahoo genutzt.

Funktionsweise

Suchmaschinen wie Google oder Bing setzen Webcrawler (oder auch Suchmaschinen-Crawler) ein, die systematisch alle Inhalte einer Website durchsuchen. Bevor ein solcher Webcrawler mit dem Crawlen beginnt, überprüft er im Rootverzeichnis, ob eine robots.txt vorhanden ist. Dort sucht er nach Regeln, die für seinen spezifischen User-Agent gelten. Der Begriff User-Agent beschreibt den Crawler-Typ, z. B. Googlebot, Bingbot oder Slurp. Enthält die Datei passende Anweisungen wie Disallow oder Allow, entscheidet der Bot anhand dieser Richtlinien, welche Seiten gecrawlt und indexiert werden. Werden keine Regeln gefunden, wird die gesamte Website gecrawlt.

Die Richtlinien in einer robots.txt-Datei regeln nicht nur den Zugriff auf bestimmte Verzeichnisse oder bestimmte Seiten, sondern auch auf bestimmte Unterverzeichnisse oder einzelne Seiten. Wichtig ist: Die robots.txt ist nur eine Empfehlung an die Crawler – sie ersetzt keinen Zugriffsschutz, wie durch eine .htaccess-Datei. Zudem gibt es Unterschiede in der Interpretation: Manche Bots ignorieren Wildcards, andere unterstützen diese vollständig. Die gängigsten Suchmaschinen halten sich jedoch an die Regeln des Robots Meta Tag oder des X Robots Tag.

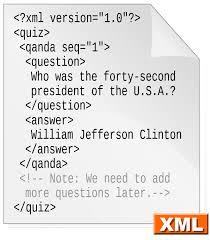

Aufbau und Syntax

Die robots.txt-Datei ist eine klassische Text-Datei, die mit einem Texteditor wie Notepad oder einem beliebigen anderen Texteditor bearbeitet werden kann. Die Datei besteht aus verschiedenen Direktiven:

- User-agent: Bestimmt, für welchen Crawler die Regel gilt. Auch pluralisch als «user-agents» bezeichnet.

- Disallow: Verbietet den Zugriff auf ein bestimmtes Verzeichnis oder eine bestimmte Seite.

- Allow: Erlaubt den Zugriff auf einzelne Seiten innerhalb eines ausgeschlossenen Bereichs.

- Crawl-delay: Legt eine Wartezeit (Engl.: Crawl Delay) zwischen den Anfragen fest.

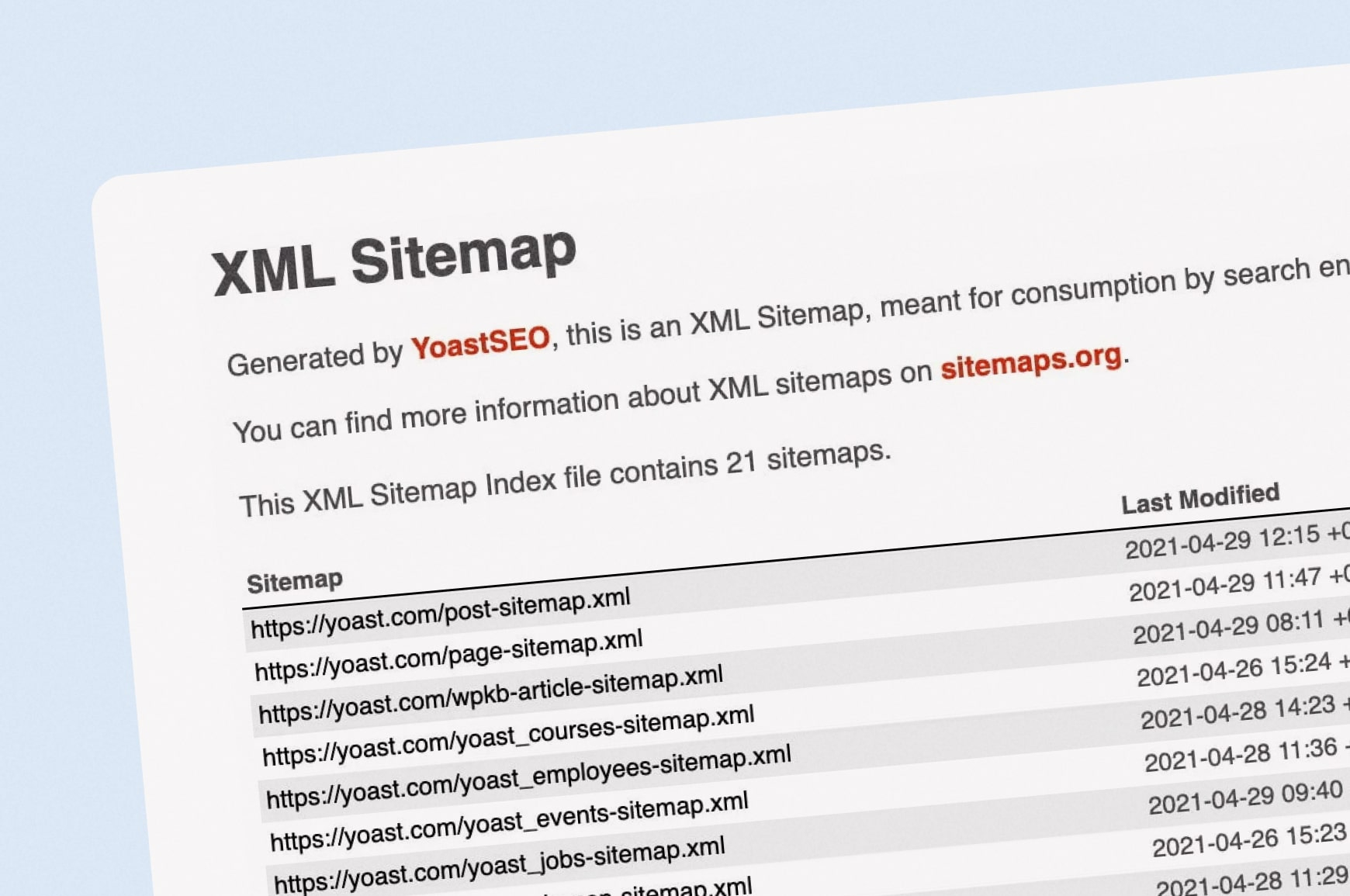

- Sitemap: Gibt die URL zur Sitemap-Datei an (z. B. sitemap.xml oder sitemaps).

Beispiel einer robots.txt-Datei

Ein Beispiel für eine strukturierte robots.txt-Datei:

User-agent: * Disallow: /privat/ Allow: /privat/news.html Crawl-delay: 5 Sitemap: https://example.com/sitemap.xml

Diese Konfiguration untersagt allen User Agents den Zugriff auf das Verzeichnis /privat/, erlaubt jedoch den Zugriff auf eine einzelne Datei. Zudem wird eine Sitemap angegeben und ein Crawl Delay gesetzt.

Vorteile & Grenzen

Vorteile:

Die robots.txt-Datei bietet zahlreiche Vorteile für Website-Betreiber:

- Gezielte Steuerung des Crawling: Du kannst genau festlegen, welche Bereiche deiner Website gecrawlt werden dürfen und welche nicht.

- Schutz vor unnötiger Serverlast: Nicht relevante Seiten – z. B. Druckansichten oder Filterseiten – können vom Crawling ausgeschlossen werden.

- Verbesserte SEO-Strategie: Durch gezielte Steuerung wird das Crawl Budget optimal genutzt und Duplicate Content vermieden.

- Individuelle Regeln pro Bot: Verschiedene Crawler wie Googlebot-Image oder Bingbot lassen sich separat regeln.

- Integration von Sitemaps: Durch die Angabe von sitemap.xml-Dateien wird die Website besser erschlossen.

Grenzen:

Trotz ihrer Vorteile hat die robots.txt-Datei auch klare Einschränkungen:

- Keine Zugriffssperre: Bots, die die Regeln ignorieren, können Inhalte trotzdem aufrufen.

- Indexierung über externe Links möglich: Ausgeschlossene Seiten können dennoch im Index erscheinen, wenn sie verlinkt werden.

- Fehleranfällig: Ein falscher Slash oder eine fehlerhafte Syntax kann weitreichende Folgen haben.

- Nicht alle Bots interpretieren Regeln gleich: Direktiven wie Crawl-delay oder Wildcards werden unterschiedlich umgesetzt.

- Keine Entfernung aus dem Index: Bereits indexierte Seiten bleiben sichtbar, wenn nur robots.txt verwendet wird.

Vergleich von robots.txt mit verwandten Technologien

Die robots.txt-Datei ist nicht das einzige Mittel, um das Verhalten von Crawlern zu beeinflussen. Im Vergleich zu verwandten Technologien gibt es wichtige Unterschiede:

- robots.txt vs. Meta Tags: Während die robots.txt Anweisungen auf Verzeichnisebene gibt, arbeiten meta-tags (z. B. ) auf Seitenebene und steuern direkt die Indexierung einzelner Seiten.

- robots.txt vs. X-Robots Tag: Der X-Robots Tag funktioniert über HTTP-Header und kann – anders als die robots.txt – auch auf nicht-HTML-Dateien wie PDFs oder Bilder angewendet werden.

- robots.txt vs. .htaccess: Der X-Robots Tag funktioniert über HTTP-Header und kann – anders als die robots.txt – auch auf nicht-HTML-Dateien wie PDFs oder Bilder angewendet werden.

Eine sinnvolle Crawling- und Indexierungsstrategie kombiniert oft mehrere dieser Werkzeuge, je nach Art und Schutzbedarf der Inhalte.

Geschichte und Hintergrund

Die Geschichte der robots.txt-Datei reicht zurück bis ins Jahr 1994, als Martijn Koster das sogenannte Robots Exclusion Protocol (REP) vorschlug. Ziel war es, Website-Betreibern ein Werkzeug an die Hand zu geben, mit dem sie Webcrawlern Anweisungen geben können, bestimmte Bereiche ihrer Website nicht zu durchsuchen. Zu dieser Zeit entstanden immer mehr automatisierte Bots, die Inhalte systematisch durchsuchten – oft ohne Rücksicht auf Serverlast oder Datenschutz. Das REP entwickelte sich rasch zum De-facto-Standard. Zwar wurde es nie offiziell von der IETF standardisiert, wird aber bis heute von allen bedeutenden Suchmaschinen beachtet. Im Laufe der Zeit sind neben der klassischen robots.txt-Datei auch verwandte Mechanismen wie das Robots Meta-Tag oder der X-Robots-Tag entstanden, um den Zugriff auf Inhalte noch feiner zu steuern.

Obwohl Direktiven wie crawl-delay, nofollow und noindex nie offiziell in der robots.txt-Spezifikation definiert waren, wurden sie lange von Google unterstützt – unter anderem auch, weil Systeme wie WordPress sie automatisch in die robots.txt integrierten. Seit 2019 werden sie jedoch nicht mehr ausgewertet.

Best Practices

Damit deine robots.txt-Datei zuverlässig funktioniert, beachte folgende bewährte Vorgehensweisen:

- Richtiger Speicherort: Lege die Datei im Rootverzeichnis unter https://example.com/robots.txt ab.

- Klare Struktur: Gruppiere Regeln nach User-agent und formuliere sie eindeutig.

- Wildcards gezielt einsetzen: Gruppiere Regeln nach User-agent und formuliere sie eindeutig.

- Sitemap angeben: Verlinke alle vorhandenen sitemap.xml-Dateien, um das Crawling zu erleichtern.

- Regelmässig prüfen: Teste die Datei mit dem robots.txt Tester der Google Search Console.

- Bei Änderungen aktualisieren: Passe die Datei bei strukturellen Änderungen oder Relaunches an.

Die häufigsten Fehler

Auch wenn die robots.txt-Datei simpel erscheint, schleichen sich häufig Fehler ein:

- Website versehentlich blockiert: Ein Disallow: / ohne genaue Prüfung kann die gesamte Website vom Crawling ausschliessen.

- Falscher Speicherort: Die Datei muss im Rootverzeichnis liegen – Unterordner werden ignoriert.

- Syntaxfehler: Fehlende Doppelpunkte, falsche Gross-/Kleinschreibung oder vergessene Slashes führen zu Fehlinterpretationen.

- Unklare Regeln: Ein Disallow: / ohne genaue Prüfung kann die gesamte Website vom Crawling ausschliessen.

- Unbedachte Wildcards: Ein zu breit gesetztes * kann wichtige Seiten blockieren.

- Vergessene Updates: Nach Relaunches oder Strukturänderungen wird die Datei oft nicht angepasst.

Anleitung

So erstellst du eine gültige robots.txt:

- Öffne einen Texteditor (z. B. Notepad)

- Schreibe deine Regeln entsprechend deiner SEO-Strategie

- Speichere die Datei als robots.txt

- Lade sie in das Stammverzeichnis deines Webservers

- Teste mit der Google Search Console oder einem robots.txt Tester

- Überwache die Funktion mit Tools oder Logfile Analysen

Tools und Validierung

Zahlreiche Tools helfen bei der Prüfung und Validierung der Datei:

- Google Search Console

- Bing Webmaster Tools von Microsoft

- robots.txt Tester und Online Validatoren

- Logfile Analyse für Crawling Verhalten

- Überwachung von einzelnen Seiten, bestimmten Verzeichnissen und PDF-Dateien