Was ist eine XML Sitemap?

Die XML-Sitemap listet Informationen zu den Seiten einer Webseite für Suchmaschinen und andere Dienste auf und kann maschinell ausgelesen werden.

Zuletzt überarbeitet: November 2025

Inhaltsverzeichnis

In der Welt der Suchmaschinenoptimierung (SEO) spielt die XML-Sitemap eine zentrale, wenngleich oft unterschätzte Rolle. Sie dient als eine Art Landkarte für Suchmaschinen wie Google, Bing, Yandex und andere. Während eine gut geplante interne Verlinkung der wichtigste Weg für Crawler wie den Googlebot ist, eine Website zu erfassen, liefert die XML-Sitemap einen zusätzlichen, strukturierten Überblick über alle relevanten Seiten, die indexiert werden sollen. Besonders für grosse, neue oder komplexe Websites ist die XML-Sitemap ein unverzichtbares Werkzeug, um sicherzustellen, dass keine wichtige Seite übersehen wird.

Begriff und Definition: Was ist eine XML-Sitemap?

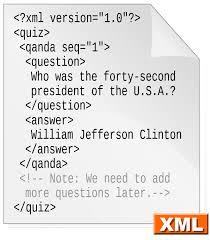

Der Begriff XML-Sitemap setzt sich aus zwei Komponenten zusammen: «XML» und «Sitemap».

- Sitemap (dt.: Seitenplan): Bezeichnet im Allgemeinen eine Übersicht über die Struktur einer Website. Es gibt die nutzerorientierte HTML-Sitemap und die maschinenlesbare XML-Sitemap.

- XML (Extensible Markup Language): Eine Auszeichnungssprache, die zur Darstellung von hierarchisch strukturierten Daten verwendet wird.

Eine XML-Sitemap ist demnach eine Datei im XML-Format, die eine Liste aller Sitemap URLs einer Website enthält, welche der Webmaster den Suchmaschinen zur Kenntnis bringen möchte. Sie wird in der Regel unter dem Namen sitemap.xml im Stammverzeichnis einer Domain gespeichert. Ihr Hauptzweck ist es, Search Engine Crawlern dabei zu helfen, alle wichtigen Inhalte einer Website zu finden, zu crawlen und in den Suchmaschinen-Index aufzunehmen. Die XML-Sitemap ist also kein Ranking-Faktor im klassischen Sinne, sondern ein Crawling- und Indexierungs-Faktor.

Aufbau und Syntax einer XML-Sitemap

Die XML-Sitemap folgt einer klaren und standardisierten Syntax, die im Sitemaps Protokoll definiert ist und unter der URL http://www.sitemaps.org/schemas/sitemap/0.9 referenziert wird. Jede XML-Sitemap beginnt mit der obligatorischen Angabe der XML-Version und der Encoding-Art, die stets UTF-8 sein muss:

<?xml version="1.0" encoding="UTF-8"?>Die zentralen Tags

<urlset>: Das urlset Tag ist das Wurzelelement der Datei. Es umschliesst alle URLs und enthält den xmlns-Namensraum, der auf das Sitemaps-Protokoll verweist:

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">- <url>: Dieses Tag ist ein Container für die Daten jeder einzelnen Seite.

- <loc>: Steht für «Location» und ist der einzige zwingend erforderliche Eintrag innerhalb des <url> Tags. Es enthält die absolute und vollständige URL der Seite, zum Beispiel https://www.example.com/seite/.

Optionale Tags

Neben dem <loc>-Tag können optionale Metadaten in der XML-Sitemap bereitgestellt werden:

- <lastmod>: Steht für lastmod (oder last modification) und gibt das Datum der letzten Änderung an der URL an. Das Format muss dem W3C-Datums- und Zeitformat entsprechen. Korrekte Angaben helfen Search Engine Crawlern, effizienter zu arbeiten.

- <changefreq>: Steht für changefreq (Change Frequency) und gibt die voraussichtliche Häufigkeit der Änderung an (z.B. hourly, daily, weekly, monthly). Es wird von Google jedoch meist ignoriert und seine Verwendung ist umstritten, da es oft ungenau ist.

- <priority>: Gibt die Priorität einer URL im Vergleich zu anderen URLs der Website an (Werte von 0.0 bis 1.0). Dieser Tag wird von Google ebenfalls weitgehend ignoriert, da die Relevanz der Seite überwiegend aus der internen Verlinkung abgeleitet wird.

Beispiel

Um die Struktur zu verdeutlichen, hier ein kurzes Beispiel für eine sitemap.xml-Datei:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>https://www.iqual.ch/de</loc>

<lastmod>2025-05-02T00:00:00Z</lastmod>

<changefreq>weekly</changefreq>

<priority>1</priority>

</url>

<url>

<loc>https://www.iqual.ch/de/seo-agentur</loc>

<lastmod>2025-05-09T00:00:00Z</lastmod>

<changefreq>monthly</changefreq>

<priority>0.9</priority>

</url>

<url>

<loc>https://www.iqual.ch/de/kontakt</loc>

<lastmod>2025-05-06T00:00:00Z</lastmod>

<changefreq>yearly</changefreq>

<priority>0.5</priority>

</url>

</urlset>Dieses XML-Format ermöglicht es dem Search Engine Crawler, die Struktur von example.com schnell zu erfassen.

Bedeutung der XML-Sitemap für SEO

Die XML-Sitemap ist ein elementarer Bestandteil der technischen SEO. Ihre Bedeutung liegt in der direkten Kommunikation mit den Suchmaschinen:

- Erkennung neuer Inhalte: Bei neuen Websites oder Seiten, die noch wenig interne oder externe Links haben, ist die XML-Sitemap oft der schnellste Weg, um Crawler auf die neuen Seiten aufmerksam zu machen.

- Crawling Effizienz: Die XML-Sitemap stellt sicher, dass Googlebots ihr Crawling Budget effizient nutzen, indem sie nur die URLs besuchen, die auch tatsächlich indexiert werden sollen. Sie vermeidet das Crawling von unnötigen Seiten.

- Umfangreiche Websites: Bei sehr grossen Websites, wie Online Shops oder Nachrichtenportalen, kann die interne Linkstruktur so komplex werden, dass nicht alle Seiten einfach zu finden sind. Die XML-Sitemap garantiert die Auffindbarkeit.

- Zusatzinformationen: Spezielle Sitemap Formate erlauben es, zusätzliche Informationen zu Video Sitemaps oder News Sitemaps (Google News) zu liefern, die über die reine URL-Liste hinausgehen.

Funktionsweise

Die Funktionsweise einer XML-Sitemap ist ein Prozess, der in mehreren Schritten abläuft:

- Generierung: Der Webmaster oder ein automatisiertes System (z.B. ein Plug-in im Content Management System) erstellt die XML-Sitemap-Datei.

- Bereitstellung: Die Datei, meist sitemap.xml genannt, wird im Hauptverzeichnis des Webservers abgelegt.

Bekanntgabe (robots.txt): Die URL der XML-Sitemap wird in der robots.txt-Datei hinterlegt, damit Search Engine Crawler sie leicht finden können. Dies geschieht durch Hinzufügen der Zeile:

Sitemap: [Sitemap URL]- Übermittlung (Search Console): Die Sitemap URL wird manuell oder automatisch bei den entsprechenden Tools der Suchmaschinen eingereicht, beispielsweise in der Google Search Console oder den Bing Webmaster Tools von Microsoft.

- Verarbeitung: Die Crawler laden und verarbeiten die XML-Sitemap, überprüfen die aufgelisteten Sitemap URLs und beginnen gegebenenfalls mit dem Crawling und der Indexierung der Seiten.

Arten

Das Sitemaps-Protokoll erlaubt die Einreichung verschiedener Sitemap-Formate, um zusätzliche Informationen zu spezifischen Inhaltstypen zu liefern:

- Standard-XML-Sitemap: Die Basisversion, die Seiten auflistet.

- Video Sitemaps: Speziell für Video-Inhalte, enthalten Metadaten wie Titel, Beschreibung, Dauer und Vorschaubild-URL. Dies ist wichtig, da Video Sitemap Daten helfen, Videos in speziellen Suchergebnissen anzuzeigen.

- News Sitemaps: Speziell für Websites, die unter Google News gelistet werden wollen. Sie müssen zusätzliche Tags wie <news:publication> und <news:publication_date> enthalten und sich strikt an die Richtlinien halten, insbesondere die 1000-URL-Grenze und die Aktualität der last modification.

- Image Sitemaps: Ermöglichen die Auflistung von Bild-URLs, die der Crawler möglicherweise nicht über die normale Analyse der Seite findet.

- Hreflang Sitemaps: Dienen der Kennzeichnung mehrsprachiger oder regionaler Alternativen von Seiten, um Duplicate Content zu vermeiden und der Suchmaschine die richtige Version für deie Nutzenden anzuzeigen.

Sitemap Index und Multiple Sitemaps

Wenn eine Website sehr umfangreich ist (über 50’000 Sitemap URLs) oder die unkomprimierte Dateigrösse 50 MB überschreitet, muss die XML-Sitemap in mehrere Sitemaps aufgeteilt werden. Um der Suchmaschine nicht alle einzelnen XML-Sitemap-Dateien übermitteln zu müssen, wird eine sogenannte Sitemap Index File verwendet.

Die Sitemap Index ist selbst eine XML-Datei, die lediglich auf die einzelnen XML-Sitemap-Dateien verweist. Sie verwendet die Tags <sitemapindex>, <sitemap> und <loc>.

Die einzelnen XML-Sitemap-Dateien können zur Reduzierung der Dateigrösse auch mit gzip komprimiert werden.

Vorteile und Grenzen

Vorteile

- Vollständigkeit: Garantiert, dass Crawler alle wichtigen, indexierbaren Seiten einer Website finden, selbst wenn die interne Verlinkung unvollständig ist.

- Geschwindigkeit: Beschleunigt die Indexierung neuer Seiten.

- Zusätzliche Informationen: Liefert Kontext über lastmod und spezielle Inhalte (Video, News).

- Wartung: Ermöglicht die Überwachung des Crawling Status und von Fehlern in der Google Search Console.

Grenzen

- Kein Ranking-Faktor: Eine XML-Sitemap verbessert nicht das Ranking, sie verbessert lediglich die Findbarkeit.

- Kein Ersatz für Links: Die XML-Sitemap ersetzt nicht eine gute interne Verlinkung. Links sind nach wie vor das primäre Mittel für Crawler zur Entdeckung.

- Keine Garantie: Die Suchmaschinen sind nicht verpflichtet, alle in der XML-Sitemap gelisteten URLs zu crawlen oder zu indexieren. Sie dient als Vorschlag.

Geschichte

Die Geschichte der XML-Sitemap ist eng mit der Entwicklung der Suchmaschinen verbunden. Das Konzept wurde ursprünglich von Google im Jahr 2005 eingeführt, um Webdesignern und SEO-Expert*innen ein Werkzeug an die Hand zu geben, mit dem sie die Indexierung ihrer Websites aktiv steuern können. Im Jahr 2006 schlossen sich Microsoft (Bing) und Yahoo dieser Initiative an, was zur Veröffentlichung des standardisierten Sitemaps-Protokolls auf sitemaps.org führte. Dies etablierte die XML-Sitemap endgültig als universellen Standard in der SEO-Welt, der bis heute von allen grossen Suchmaschinen akzeptiert wird.

Anleitung zur Erstellung und Einreichung der XML-Sitemap

Die Erstellung einer XML-Sitemap erfolgt heute meist automatisiert:

- Content Management System (CMS): Bei Systemen wie WordPress wird die XML-Sitemap in der Regel über Plug-ins wie Yoast SEO oder Rank Math generiert. Diese Plug-ins erstellen die XML-Sitemap-Datei dynamisch bei jeder Änderung (last modification) der Inhalte und berücksichtigen dabei automatisch die XML-Format-Regeln und das UTF-8-Encoding.

- Sitemap Generator: Für statische Seiten oder Websites ohne CMS können externe Sitemap-Generatoren genutzt werden, die die Website crawlen und die sitemap.xml-Datei zum Download bereitstellen.

- Manuelle Erstellung: Für sehr kleine Websites ist auch eine manuelle Erstellung im Extensible Markup Language Format möglich, muss aber bei jeder Änderung aktualisiert werden.

Einreichung

- Hochladen: Die generierte XML-Sitemap-Datei (sitemap.xml) muss in das Stammverzeichnis des Webservers hochgeladen werden, damit sie unter einer Sitemap URL wie https://www.example.com/sitemap.xml erreichbar ist.

- robots.txt: Füge die Zeile Sitemap: [Sitemap URL] zur robots.txt-Datei hinzu.

- Google Search Console: Melde dich in der Google Search Console an, navigiere zum Abschnitt «Sitemaps» und gib die vollständige Sitemap URL an.

- Bing Webmaster Tools: Analog erfolgt die Einreichung bei den Bing Webmaster Tools.

Best Practices

Um eine optimale Wirkung im Rahmen der SEO zu erzielen, sollten folgende Best Practices beachtet werden:

- Ausschliesslich Indexierbares: Nehme nur kanonische Sitemap URLs mit dem HTTP-Statuscode 200 auf. Schliessen URLs mit noindex, 404-Fehlerseiten, Weiterleitungen oder Duplicate Content aus.

- Absolute URLs: Verwende immer vollständig qualifizierte, absolute URLs (z.B. https://www.example.com/seite/), niemals relative Pfade.

- Konsistente URLs: Die Protokollversion (HTTP vs. HTTPS) und die www-Verwendung müssen konsistent mit der bevorzugten Version deiner Website sein.

- Aktualität: Halte das Feld lastmod (letzte Änderung) so aktuell wie möglich, um Crawlern bei der erneuten Prüfung zu unterstützen. Bei dynamischen Websites sollte die XML-Sitemap automatisch aktualisiert werden.

- Strukturierung: Bei sehr grossen Projekten solltest du die URLs thematisch oder nach Inhaltstyp (z.B. Blog, Produkte, Kategorien) in einzelne XML-Sitemap-Dateien aufteilen und diese in einem Sitemap Index File zusammenfassen.

Die häufigsten Fehler

Trotz ihrer Wichtigkeit werden oft Fehler beim Umgang mit der XML-Sitemap gemacht, die das Crawling behindern:

- Aufnahme von nicht-kanonischen oder blockierten URLs: Die häufigste Fehlerquelle ist die Aufnahme von URLs, die über die robots.txt-Datei blockiert sind oder einen noindex Tag tragen. Dies sendet widersprüchliche Signale an den Crawler.

- Falsches Format und Encoding: Die Datei muss strikt dem XML-Format folgen und UTF-8-Encoding verwenden. Fehler in der Syntax oder im Encoding führen dazu, dass der Crawler die Datei nicht lesen kann.

- Veraltete Sitemaps: Bei manuell erstellten Sitemaps wird vergessen, neue Seiten hinzuzufügen oder gelöschte zu entfernen, wodurch der Crawler unnötige Seiten besucht oder wichtige Seiten übersieht.

- Überschreitung der Limits: Das Limit von 50’000 Sitemap URLs oder 50 MB Dateigrösse (unkomprimiert) pro XML-Sitemap-Datei wird ignoriert, was zum Abbruch der Verarbeitung durch die Suchmaschinen führt. Die Lösung hier ist die Verwendung eines Sitemap Index.

Tools und Validierung der XML-Sitemap

Eine XML-Sitemap sollte vor der Einreichung immer auf Fehler überprüft werden, da eine fehlerhafte Datei das Crawling negativ beeinflussen kann.

- Google Search Console / Bing Webmaster Tools: Beide Plattformen bieten einen Sitemap-Test- und Einreichungsbereich. Hier kann der Status der eingereichten XML-Sitemap überwacht und mögliche Fehler (z.B. 404-Fehler in den gelisteten URLs) direkt eingesehen werden.

- Sitemap Generator / Plug-in: Die meisten hochwertigen Sitemap Generators und Plug-ins (WordPress) bieten eine eingebaute Validierung, die sicherstellt, dass das XML-Format und die Encoding-Regeln eingehalten werden.

- Online Validatoren: Es gibt spezialisierte Online Tools, die eine Sitemap URL überprüfen und auf Syntax- oder Protokollfehler hinweisen.

Durch die konsequente Pflege und Nutzung der XML-Sitemap wird sichergestellt, dass Search Engine Crawlers eine vollständige und aktuelle Übersicht aller relevanten Seiten erhalten.